Copilot

预安装和部署准备

系统要求

硬件要求:

- CPU:Intel/AMD 32核或更高

- 内存:256GB RAM或更高

- 存储:至少200GB可用磁盘空间

- GPU:必须支持CUDA。内存大于40GB。建议使用Ampere架构或更高(例如A100、RTX 4090)。

软件要求:

- 操作系统:Ubuntu 22.04

- CUDA:建议≥11.8(兼容Ampere架构)

- NVIDIA驱动:≥535.x

- Docker:≥20.10(必须安装NVIDIA Container Toolkit)

AI包

请联系销售获取AI docker镜像。将AI docker镜像xiangyu-ai.tar保存到服务器。

安装步骤

预安装检查:

- NVIDIA驱动和CUDA:运行命令

nvidia-smi验证驱动版本和CUDA版本是否满足软件要求中指定的要求

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 560.35.03 Driver Version: 560.35.03 CUDA Version: 12.6 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA L40 On | 00000000:08:00.0 Off | 0 |

| N/A 73C P0 107W / 300W | 1603MiB / 46068MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

| 1 NVIDIA L40 On | 00000000:09:00.0 Off | 0 |

| N/A 47C P0 84W / 300W | 10817MiB / 46068MiB | 0% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| 0 N/A N/A 7072 C text-embeddings-router 1594MiB |

| 1 N/A N/A 309241 C ...rs/cuda_v12_avx/ollama_llama_server 10808MiB |

+-----------------------------------------------------------------------------------------+

- Docker环境检查:运行命令

docker --version验证Docker版本是否满足软件要求中指定的版本。例如:

Docker version 27.4.1, build b9d17ea

- NVIDIA Container Toolkit检查:运行命令

nvidia-container-runtime --version验证NVIDIA Container Toolkit已安装并运行。例如:

NVIDIA Container Runtime version 1.17.4

commit: 9b69590c7428470a72f2ae05f826412976af1395

spec: 1.2.0

runc version 1.2.2

commit: v1.2.2-0-g7cb3632

spec: 1.2.0

go: go1.22.9

libseccomp: 2.5.3

AI包安装

-

将祥宇AI镜像文件下载到本地。

-

运行以下命令将镜像加载到本地Docker库中。

docker load -i xiangyu-ai.tar -

运行以下命令加载LLM。

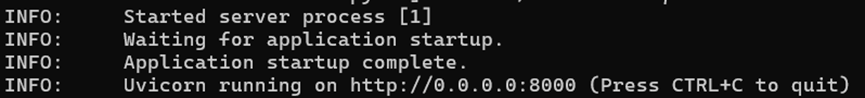

docker run --runtime nvidia --gpus all -p 8000:8000 --ipc=host xiangyu-ai:0.7.2 --model /models --served-model-name Qwen2.5-Coder-14B-Instruct当屏幕上出现以下信息时,表示模型已成功加载。

配置Copilot扩展

-

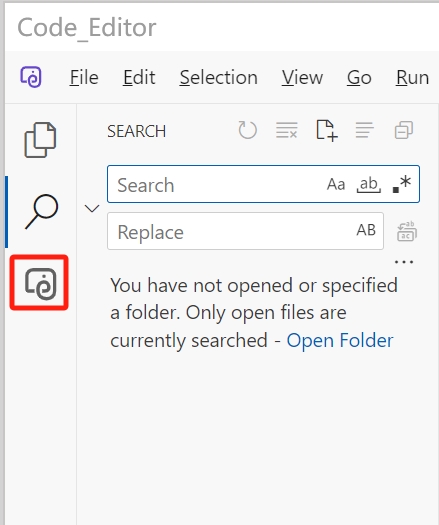

在上位机软件中打开祥宇AI代码助手界面。

-

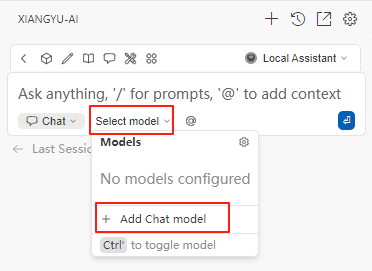

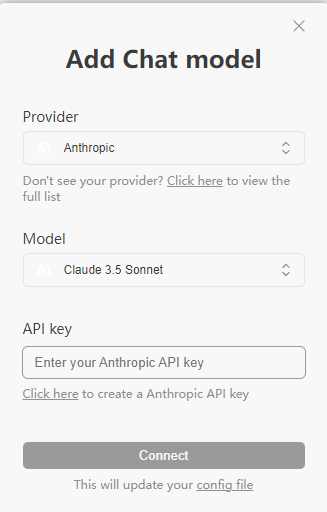

点击下图所示的

选择模型图标配置AI模型访问信息,然后选择添加聊天模型。

-

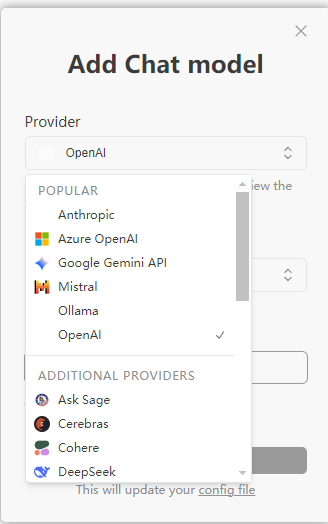

在弹出窗口中,选择合适的模型

-

对于中国大陆以外的用户,建议选择Anthropic或OpenAI。从列表中选择合适的模型并输入您申请的API密钥。

-

对于中国大陆的用户,建议选择Deepseek。从列表中选择合适的模型(例如Deepseek-coder)并输入您申请的API密钥。

-

要添加本地部署的模型,点击下面的配置文件链接打开

config.yaml文件。

-

按以下规范配置AI模型访问信息。模型

OpenAI/Qwen2.5-Coder-14B-Instruct是指上述AI包安装部分的配置示例。如果通过ollama本地部署模型,请参考- name: qwen2.5-coder 3b配置示例。根据您的部署信息填写适当的参数(模型名称、apiBase等)。name: Local Assistant

version: 1.0.0

schema: v1

models:

- name: OpenAI/Qwen2.5-Coder-14B-Instruct

provider: openai

model: Qwen2.5-Coder-14B-Instruct

apiBase: http://x.x.x.x:8000/v1

apiKey: test

roles:

- chat

- edit

- apply

- autocomplete

- name: qwen2.5-coder 3b

provider: ollama

model: qwen2.5-coder:3b

apiBase: http://x.x.x.x:11434

roles:

- chat

- edit

- apply

- autocomplete

defaultCompletionOptions:

contextLength: 32768

maxTokens: 20480

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase